구글, 네이버, 다음, 빙과 같은 포털에서 robots.txt 파일에 등록되어 있는 정보로 웹사이트 및 블로그의 글을 크롤링 해간다.

이때 robots.txt 파일은 검색엔진 로봇이 홈페이지/블로그에 들어와도 되는지, 글을 수집해도 되는지, 수집하면 안되는지를 알여주는 기능을 한다.

처음 robots.txt의 내용을 확인하면 이게 무엇을 뜻하는지 어렵기만 하다. 하지만 내용을 알고 보면 그러 어려집 않다.

지금부터 robots.txt에는 어떤것이 있고, 어떤 의미가 있는지 알아보고 정리해보았다.

① robots.txt 란?

② robots.txt 기본구성/용어설명

③ robots.txt 내용 분석

티스토리 블로그 robots.txt 확인 및 분석

=

robots.txt 란?

▶ robots.txt

- robots.txt는 검색로봇에게 사이트 및 웹페이지를 수집할 수 있도록 허용하거나 제한하는 국제 권고안이다.

- robots.txt 파일은 항상 사이트의 루트 디렉터리에 위치해야 하며 로봇 배제 표준을 따르는 일반 텍스트 파일로 작성해야 한다. 만약 사이트의 루트 디렉터리에 robots.txt 파일이 없다면 모든 콘텐츠를 수집할 수 있도록 간주한다.

- 간혹 특정 목적을 위하여 개발된 일부 불완전한 검색로봇은 robots.txt 내의 규칙을 준수하지 않을 수 있다. 이런경우 개인 정보를 포함하여 외부에 노출되면 안 되는 콘텐츠의 경우 로그인 기능을 통하여 보호하거나 다른 차단 방법을 사용해야한다.

▶ 포털 검색엔진 로봇 이름

▷ Daum robots Name : Daumoa

▷ Google robots Name : Goolebot

▷ Yahoo robots Name : Yahoo! Slurp

▷ Microsoft robots Name : Msnbot

▷ Bing robots Name : Bingbot

▶ robots.txt 위치

Robots.txt 파일은 반드시 사이트의 루트 디렉터리에 위치해야 하며 텍스트 파일로 접근이 가능해야 한다.

=

robots.txt 기본구성/용어설명

- 주소입력창에 위와같은 형태로 입력하면 아래와 같은 결과가 나온다.

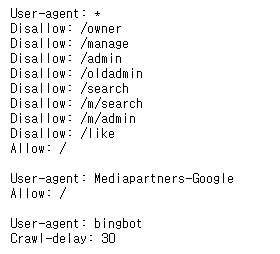

▶ 티스토리 robots.txt

Disallow: /owner

Disallow: /manage

Disallow: /admin

Disallow: /oldadmin

Disallow: /search

Disallow: /m/search

Disallow: /m/admin

Disallow: /like

Allow: /

User-agent: Mediapartners-Google

Allow: /

User-agent: bingbot

Crawl-delay: 30

▶ robots.txt 구성/의미

① 기본구성

Disallow:

Allow:

Crawl-delay:

② 용어 설명

Disallow: / → 로봇의 접근을 제한하는 디렉터리 또는 파일(첫 글자 대문자)

Allow: / → 로봇의 접근을 허용하는 디렉터리 또는 파일(첫 글자 대문자)

Crawl-delay: → 로봇의 방분을 초 단위에 한번만 방문허용

* → 와일드카드를 의미하며, 모든 대상을 의미한다.

/ → 루트 경로를 의미하며, 하위의 모든 디렉터리를 포함한다.

$ → 특정 파일이름이나 확장자를 포함한 경우를 의미한다.

=

robots.txt 내용 분석

① 모든 검색엔진 로봇의 수집/접근 허용

Allow: /

② 모든 검색엔진 로봇의 수집/접근 차단

Disallow: /

③ 모든 검색엔진 로봇의 /owner, /manage, /admin, /oldadmin, /search, /m/search, /m/admin, /like 디렉토리 수집/접근 차단

Disallow: /owner

Disallow: /manage

Disallow: /admin

Disallow: /oldadmin

Disallow: /search

Disallow: /m/search

Disallow: /m/admin

Disallow: /like

④ 구글 애드센스의 루트 이하 모든 카테고리 수집 허용

Allow: /

⑤ 빙 검색엔진 로봇 크롤링 딜레이 설정(웹사이트 30초 단위로 방문하라는 의미)

Crawl-delay: 30

지금까지 티스토리 블로그 robots.txt 에 대해 알아보았다.

도움이 되셨다면 로그인 없이 가능한

아래 하트♥공감 버튼을 꾹 눌러주세요!

'B7 블로그 > 티스토리' 카테고리의 다른 글

| 티스토리 스킨 - 공통 치환자(공통, 홈 커버, 스킨 옵션) (0) | 2019.03.22 |

|---|---|

| 티스토리 스킨 - 파일 구조, 스킨 정보 파일(index.xml), 치환자 구조 (0) | 2019.03.21 |

| 티스토리 블로그 2019년 2월 애드센스 수익공개 (0) | 2019.03.12 |

| 티스토리 블로그 2019년 1월 애드센스 수익공개 (0) | 2019.02.07 |

| 티스토리 블로그 12월 애드센스 수익공개 (0) | 2019.01.11 |